Il tuo primo AI Agent con n8n - Tutorial Pratico

Hai installato n8n seguendo la guida Docker? Perfetto. Ora è il momento di sporcarsi le mani e creare qualcosa di concreto.

Oggi costruiremo insieme il tuo primo AI Agent conversazionale. Niente di astruso o teorico: un agente reale, funzionante, che risponde alle tue domande come un assistente virtuale.

DISCLAIMER: Mi piacerebbe dirti che in 10 minuti potrai rimpiazzare il tuo reparto Marketing, ma non è vero. Però in 10 minuti posso farti venire in mente delle idee che faranno tremare il tuo reparto Marketing. Su questo ci metto la firma.

Cosa Costruiremo

Un workflow n8n composto da:

- Un’interfaccia chat accessibile via browser

- Un agente AI alimentato dal LLM che preferisci (OpenAI, Anthropic, Gemini…)

- Una memoria conversazionale che ricorda il contesto

- La possibilità di personalizzare comportamento e personalità dell’agente

Il tutto self-hosted sul tuo Docker locale, senza spendere un euro (a parte i token del LLM, ovviamente).

Prerequisiti

- n8n installato e funzionante (vedi guida Docker)

- Una API key di un provider LLM (OpenAI, Anthropic, Google, ecc.)

- 10 minuti di tempo

- Tanta voglia di sperimentare

Il Concetto di Trigger

Prima di iniziare, fermiamoci un attimo sulla filosofia dei workflow n8n.

I workflow sono essenzialmente funzioni backend. Il trigger è ciò che fa partire l’esecuzione della funzione.

I trigger possono essere:

- Webhook: attivazione via chiamata HTTP

- Chat Trigger: attivazione da messaggio chat (quello che useremo oggi)

- Scheduler: attivazione temporizzata

- Trigger Manuale: attivazione… manuale

- Sub-workflow: evocato da un altro workflow

Il trigger non solo fa partire il workflow, ma porta con sé gli argomenti della funzione: nel caso del Chat Trigger, il messaggio dell’utente e il suo Session ID.

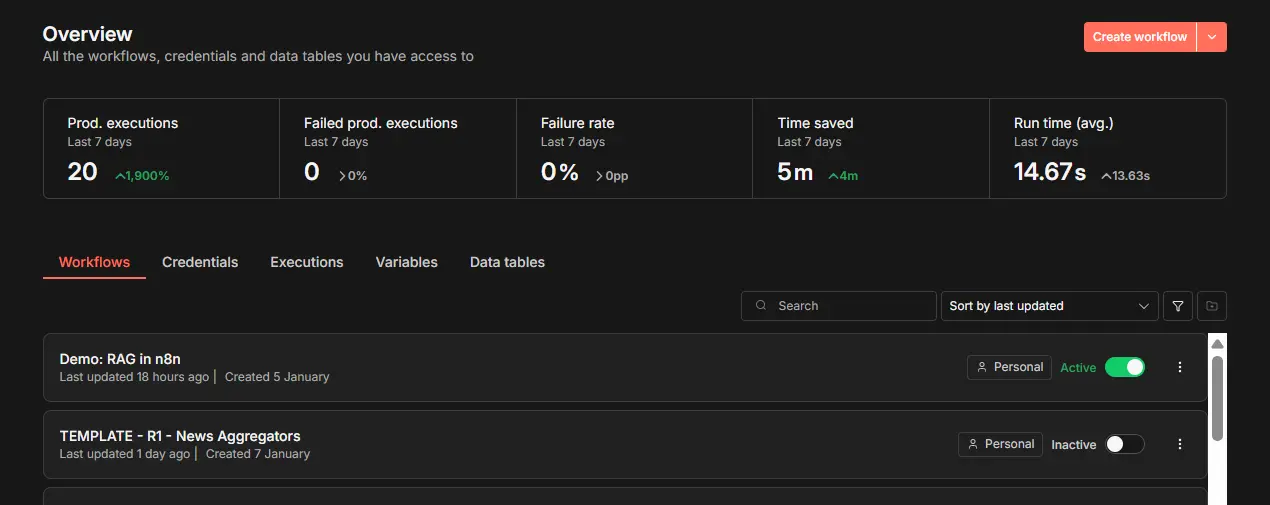

Step 1: Crea il Workflow

Accedi a n8n e:

- Clicca su “Create Workflow” in alto a destra

- Clicca su “My Workflow” in alto a sinistra e rinomina (es. “Il Mio Primo Agent”)

- Salva con Cmd+S (Mac) o Ctrl+S (Windows/Linux)

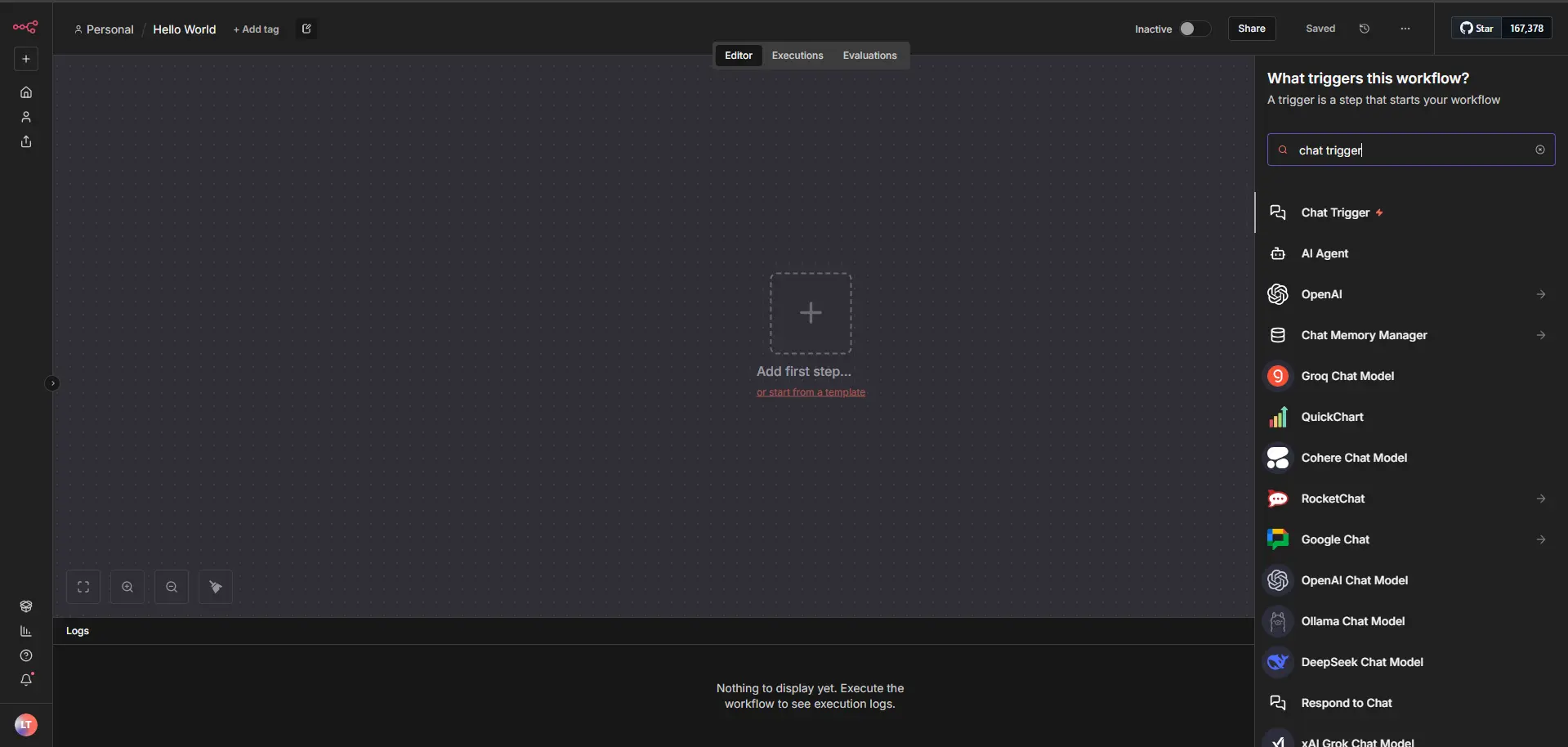

Step 2: Chat Trigger - La Porta d’Ingresso

Clicca al centro dello schermo su “Add First Step” e seleziona “Chat Trigger”.

Configurazione Base

L’unica cosa fondamentale da fare:

- Make Chat Publicly Available: impostalo su

True

Questo abilita un’interfaccia chat hostata direttamente da n8n, accessibile via link a chiunque tu voglia condividerlo.

Opzioni Interessanti (opzionali, ma utili)

- Mode: lascia su

Hosted Chatper semplicità - Authentication: su

Noneper ora (poi potrai aggiungere Basic Auth o N8N User Auth) - Initial Messages: personalizza il messaggio di benvenuto

- Response Mode: IMPORTANTE - cambia da

When Last Node FinishesaUsing Response Nodes

Perché Response Nodes?

La modalità di default risponde con l’output dell’ultimo nodo. Scomodo per il testo, pessimo per il Markdown.

Con “Response Nodes” usi un nodo dedicato Respond to Chat per controllare esattamente cosa e come rispondere.

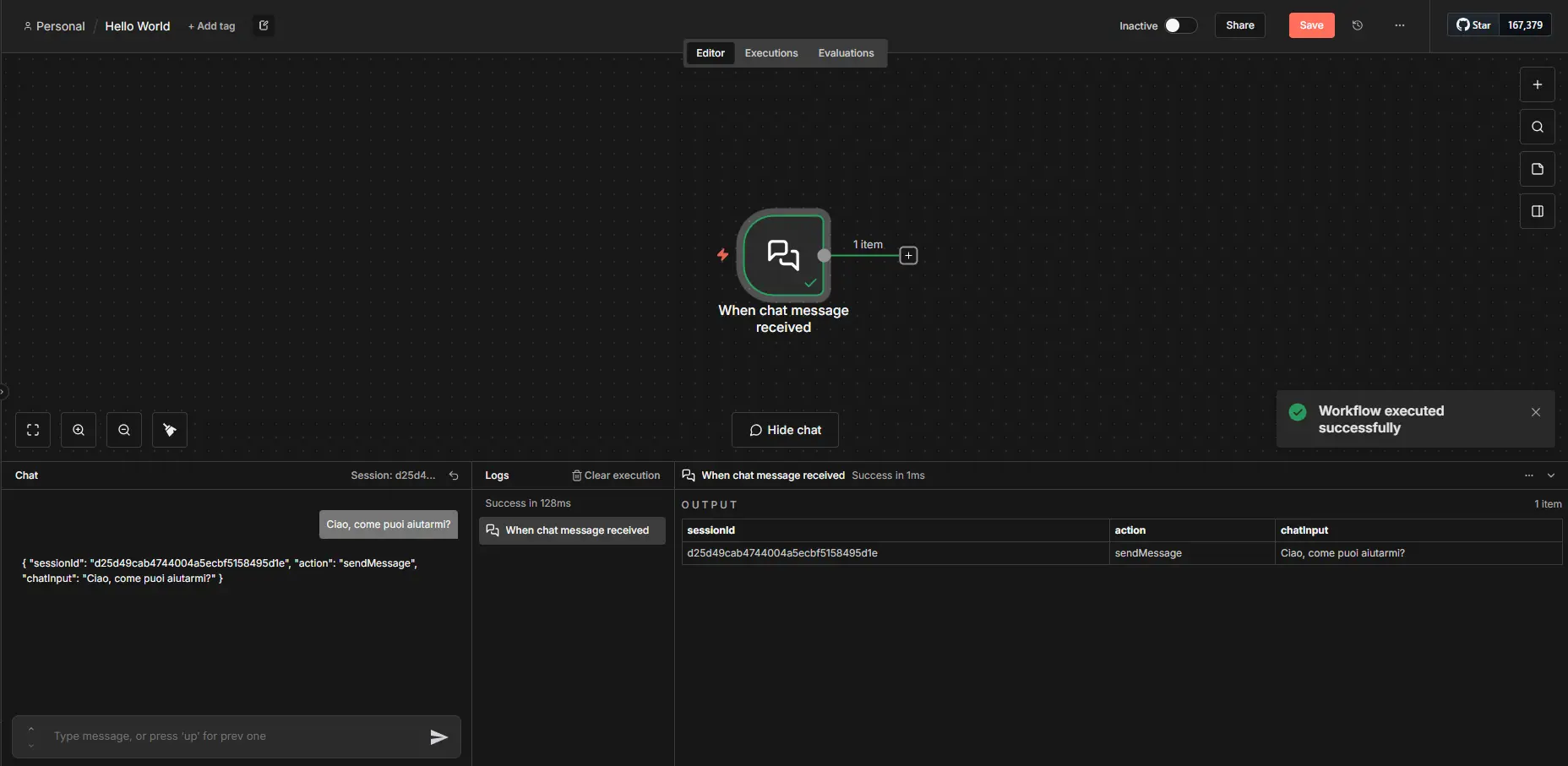

Test del Trigger

- Passa il mouse sul nodo Chat Trigger e clicca “Open Chat” (o premi

C) - Si aprirà un pannello in basso: Chat a sinistra, Logs a destra

- Scrivi un messaggio di test: “Ciao, come puoi aiutarmi?”

- Premi Invio

Il nodo diventerà verde e i log si popoleranno.

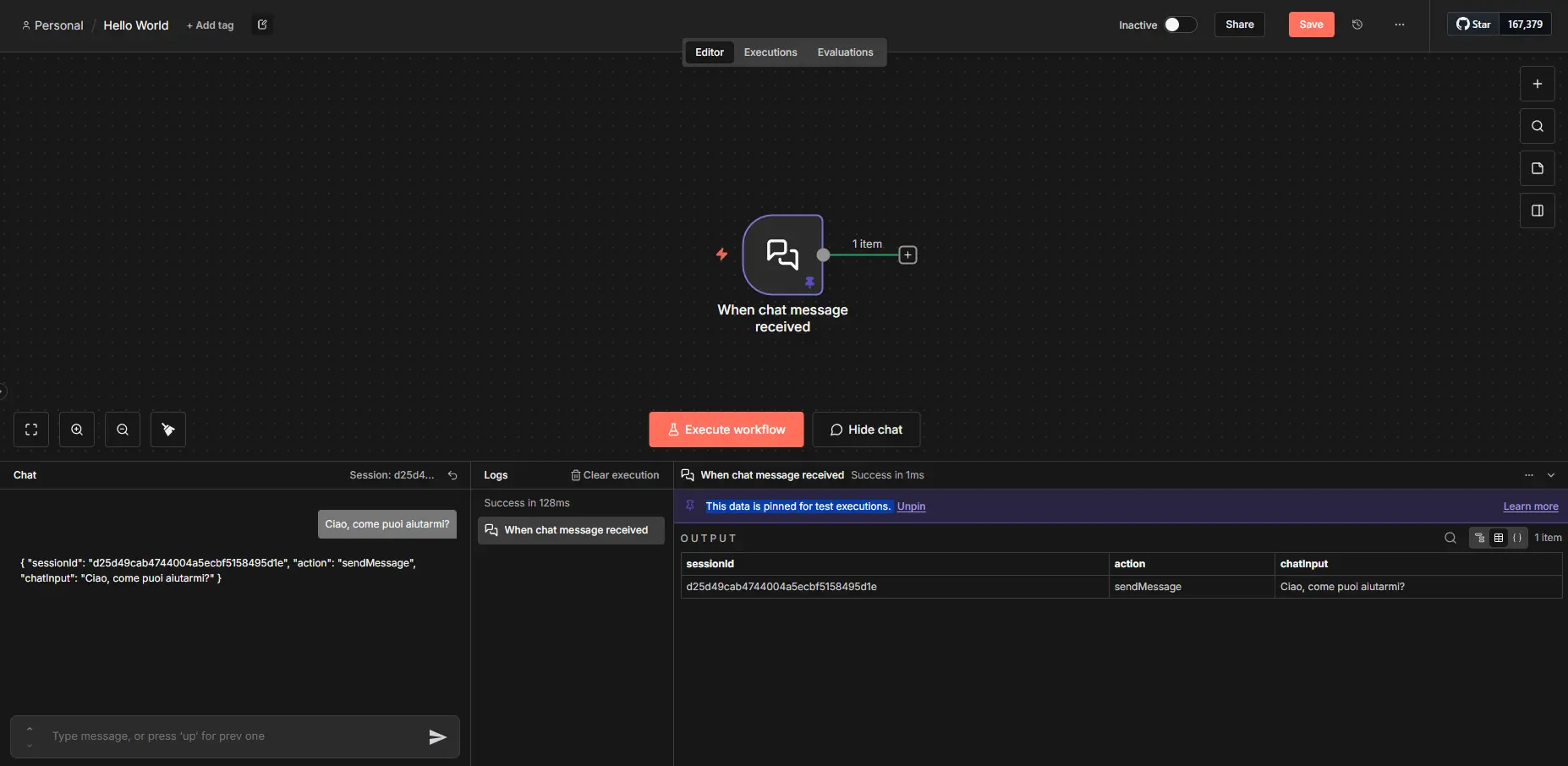

Il Trucco del PIN

Seleziona il nodo Chat Trigger (outline grigio) e premi P per pinnare i dati.

I nodi con dati pinnati diventano viola e conservano l’output per test futuri senza dover rigenerare tutto.

Pro tip: Pinna sempre quando lavori con LLM. Risparmierai token, tempo e CO2.

Step 3: Extract Chat Data - Pulizia dei Dati

Clicca sul + alla destra del Chat Trigger e aggiungi un nodo “Edit Fields (Set)”.

Rinominalo in “Extract Chat Data” per chiarezza.

Cosa Fa Questo Nodo?

È come dichiarare variabili nello scope della funzione: estrae e normalizza i dati per uso futuro. Fondamentale nei workflow complessi per mantenere ordine e sanità mentale.

Configurazione

- Visualizza l’input in modalità Schema o JSON (evita Table se non per esplorare)

- Trascina “Chat Input” dall’Input a “Fields to Set”

- Trascina “Session ID” dall’Input a “Fields to Set”

Clicca “Execute Step” in alto a destra per testare.

Poi pinna anche questo nodo (tasto P).

Step 4: AI Agent - Il Cervello

Clicca sul + alla destra di “Extract Chat Data” → “AI” → “AI Agent”.

Configurazione Input

L’AI Agent di default cerca un Chat Trigger connesso direttamente, ma noi abbiamo un nodo intermedio.

Cambia “Prompt” da Connected Chat Trigger Node a Define Below e trascina il “Chat Input” dal nodo “Extract Chat Data” nel campo “Text”.

System Prompt - La Personalità

Clicca “Add Option” → “System Message”.

Qui definisci il comportamento dell’agente, di base il System Prompt è:

You are a helpful assistant.

È generico? Sì. Ma puoi sbizzarrirti:

Sei un esperto di automazioni e pizze.

Rispondi in modo conciso ma esaustivo.

Usa esempi pratici del mondo della panificazione quando possibile.

Mantieni un tono amichevole ma professionale.

Attenzione: System Prompt + User Prompt = consumo token. Più è lungo, più costa.

Step 5: Collegare un LLM

Noterai che l’AI Agent ha un warning rosso ⚠️ e che sotto il nodo ci sono 3 slot:

- Chat Model (obbligatorio)

- Memory

- Tools

Clicca su “Chat Model” e seleziona il tuo provider preferito.

Setup OpenAI (o altro provider)

- Seleziona OpenAI Chat Model (o il tuo provider)

- Clicca “Create New Credential”

- Inserisci la tua API Key

- Rinomina le credenziali (es. “OpenAI - Main Account”)

- Scegli un Model dalla lista (es.

gpt-4.1-nanoper risparmiare) - Salva

Il warning scomparirà.

Test dell’Agent

- Clicca “Execute Workflow” in alto

- Il workflow userà i dati pinnati senza riscrivere in chat

- Aspetta che l’AI Agent diventi verde

- Apri il nodo per vedere l’output nella sezione “Output”

Pinna anche questo output (tasto P) per i test futuri.

Step 6: Respond to Chat - La Risposta

Ultimo nodo! Clicca sul + alla destra dell’AI Agent → “Respond to Chat”.

Trascina l’“Output” dell’AI Agent nel campo “Message”.

Opzionalmente, in “Options”:

- Disattiva “Wait for User Reply” se non serve feedback immediato

Step 7: Memory - Ricordare il Contesto

Torna sul nodo AI Agent e clicca su “Memory” → “Window Buffer Memory”.

Configurazione

- Session Key: cambia da

Connected Chat Trigger NodeaDefine Below - Trascina il “Session ID” dal nodo “Extract Chat Data”

- Context Window Size: imposta su

5(numero di scambi da ricordare)

Nota: La Window Buffer Memory è una cache temporanea in n8n, non un database vero. Per conversazioni serie servono soluzioni più robuste (ne parleremo nei prossimi episodi!).

Step 8: Attivazione e Test

- Salva il workflow (Cmd+S / Ctrl+S)

- In alto a destra, clicca sul flag “Inactive” → diventerà “Active”

- Apri il nodo Chat Trigger

- Copia il “Chat URL”

- Apri il link in una nuova scheda

Congratulazioni! Hai il tuo primo AI Agent funzionante.

E ora?

Questo è un agente basic, essenzialmente un wrapper attorno a un LLM. Ma è la fondazione su cui costruire:

- Tools: Dai all’agente accesso a API, database, ricerche web

- Routing: Crea agenti specializzati per task diversi

- RAG: Integra knowledge base personalizzate

- Multi-step: Flussi complessi con decisioni condizionali

Nei prossimi post esploreremo tutto questo e oltre.

Tips & Tricks

Il Potere del PIN

Pinna sempre quando sviluppi con LLM. Risparmierai:

- 💰 Denaro (meno token consumati)

- ⏱️ Tempo (niente attese per risposte)

- 🌱 CO2 (sì, ogni chiamata LLM ha un costo ambientale)

Per approfondimenti sul costo ambientale della tecnologia, segui Valeria Salis.

Visualizzazione dei Dati

- Schema: Migliore per sviluppo, mostra struttura dati

- JSON: Perfetto per debug e manipolazione avanzata

- Table: Solo per esplorazione iniziale

Esecuzioni di Test

Nodi pinnati = icona provetta 🧪 nelle executions. Vai su “Executions” tab per vedere lo storico.

Troubleshooting

“Il workflow non risponde”

- Verifica che sia Active

- Controlla che Response Mode sia su “Using Response Nodes”

- Verifica le credenziali del LLM

“Errore API Key”

- Controlla di aver salvato correttamente le credenziali

- Verifica di avere credito sul tuo account LLM

“Le risposte sono inconsistenti”

- Pinna i nodi per test ripetibili

- Verifica il System Prompt

- Controlla la temperature del model (nei settings avanzati, permette di impostare il livello di creatività delle risposte)

Conclusione

Hai appena costruito il tuo primo agente AI conversazionale. È semplice? Sì. È potente? Assolutamente. È solo l’inizio? Lo puoi dire forte.

Nei prossimi post vedremo come:

- Collegare Open Router per usare modelli free

- Aggiungere Tools per dare superpowers all’agente

- Implementare routing per agenti multi-purpose

Stay tuned, e nel frattempo… sperimenta!

La magia di n8n è che puoi rompere tutto, ricominciare e imparare. È il playground perfetto per il Project Oriented Learning.

Hai domande? Dubbi? Scoperte epiche? Condividi nei commenti!

Link Utili: