Ban di ChatGPT da Stack Overflow

Il celebre sito di Q&A per sviluppatori e sviluppatrici nelle ultime settimane è stato inondato di risposte ottenuto grazie all’utilizzo di ChatGPT, risposte che sembrano corrette ma spesso non lo sono, tanto che i moderatori hanno chiesto un momentaneo ban.

Cos’è successo?

ChatGPT

ChatGPT si basa sul modello linguistico GPT-3 di OpenAI. Le persone hanno rapidamente scoperto che, sebbene risponda agli input in un modo “umano”, ci sono dei difetti nelle risposte che fornisce.

Da quando è stato lanciato, è stato utilizzato in numerosi modi, tra cui la richiesta di scrivere del codice e/o correggere errori di codifica: questo perché il chatbot può fornire delle risposte molto velocemente, mentre chi inserisce l’input fornisce maggiori dettagli sulla richiesta.

La stessa Open AI ha però rilevato, nei numerosi esempi e studi fatti, che ChatGPT a volte scrive “risposte plausibili ma errate o prive di senso”.

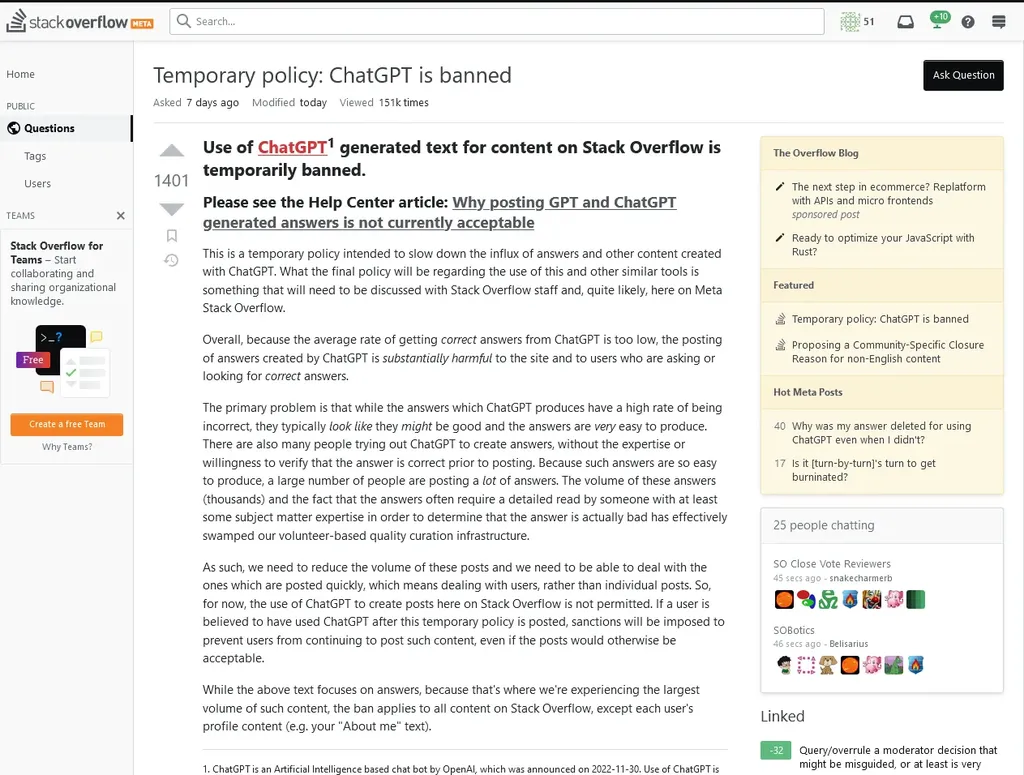

Ban da Stack Overflow

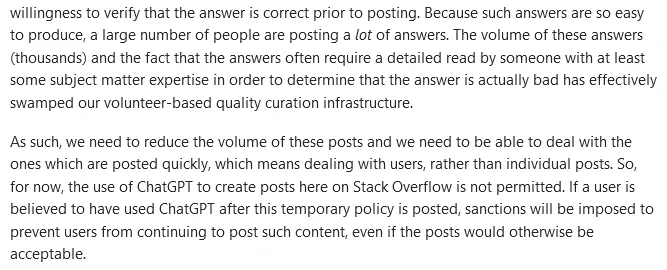

Quella appena descritta sembra infatti essere una delle cause principali del suo ban su Stack Overflow -con sanzioni per gli utenti che hanno sfruttato questo sistema per fornire delle risposte ai quesiti presenti sul sito- poiché il tasso medio di risposte corrette da ChatGPT si è dimostrato troppo basso, tanto che il sito reputa la pubblicazione di risposte create da ChatGPT è sostanzialmente dannosa per il sito e per gli utenti che chiedono o cercano risposte corrette.

Inoltre, poiché ChatGPT genera risposte così rapidamente, alcuni utenti forniscono molte risposte generate da esso senza analizzarle per verificarne la correttezza, per guadagnare punteggio e/o visibilità su questo portale.

Il problema sta nell’avere delle risposte di cui non si ha un reale confronto o expertise che ne possa garantire l’autorevolezza.

Le persone che pubblicano risposte tramite ChatGPT su StackOverflow per guadagnare più punti senza sapere se la risposta è effettivamente corretta è uno di quei problemi che era abbastanza ovvio da prevedere.

Stack Overflow ha rilevato post generati da ChatGPT nell’ordine delle migliaia al giorno. Questo rappresenta un problema per i moderatori, dal momento che molte risposte richiedono un’analisi dettagliata da parte di qualcuno con esperienza in materia per determinare se la risposta è corretta o sbagliata.

Perché sì

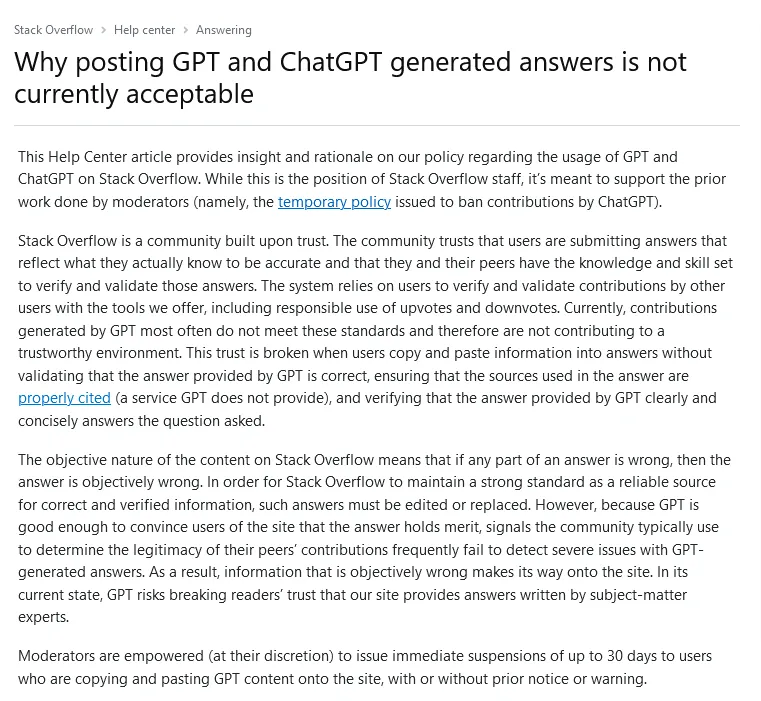

StackOverflow è un luogo in cui gli sviluppatori si collegano continuamente per risolvere dei problemi. La risoluzione di questi problemi richiede risposte che abbiano una precisione micrometrica, che dipende dal contesto, dalle esigenze, e dalle esperienze pregresse.

StackOverflow ha degli standard molto alti, non solo per le risposte, ma anche per le domande. Le persone che si occupano di moderare hanno storicamente scoraggiato i programmatori principianti dal pubblicare prematuramente domande.

La pratica sembra ingiusta a molte persone, ma ha lo scopo di addestrare sviluppatori e sviluppatrici a provare prima una ricerca con termini migliori per riformulare la loro domanda con dettagli pertinenti.

Questo è un punto dolente che molte delle persone alle prime armi sviluppatori odiano, ma riporta dei vantaggi a lungo termine, in quanto rafforza il proprio “muscolo” critico e una maggiore autonomia, utili per diventare degli/delle ottimi/e programmatori/trici.

Ancora più importante, questo sistema è gestito tramite una moderazione fatta di volontari/e che donano il loro tempo per eliminare i contenuti duplicati e valutare lo sforzo di chi fa la domanda e la sincerità di chi risponde (che dovrebbe includere principalmente codice funzionante ed efficiente).

Quest’ultimo punto rende impossibile per chi modera mantenere lo standard della qualità per il forum con questo volume di risposte. Dopotutto, se qualcuno può pubblicare risposte per guadagnare punti veloci, lo stesso può essere fatto anche con la pubblicazione di domande. Perché anche le domande permettono di scalare la vetta.

Più domande, più risposte, più punti senza alcun rischio, e il selvaggio selvaggio west della non moderazione si materializzerebbe prima del previsto.

La seguente regola si applica non solo nella tecnologia, ma ovunque nel mondo:

Quando l’impegno nei confronti di qualcosa viene ridotto al minimo, il rischio è un’offerta di bassa qualità.

Il dilemma che riguarda la creatività e l’uso di questi strumenti è stato ampiamente discusso da molti/e professionisti/e del settore: chi programma ha paura di perdere il lavoro a causa di strumenti come Chat GPT 3.0, o chi dipinge e teme che le proprie opere possano essere sfruttate da queste piattaforme per crearne di nuove.

Probabilmente, il punto più importante non è però quello dell’obsolescenza: bisognerebbe valutare piuttosto lo sfruttamento spietato dei sistemi di supporto che alimentano i motori della conoscenza, come in questo caso, StackOverflow.

L’onere di rendere il mondo protetto “eticamente” dall’IA dovrebbe spettare alle aziende che sfruttando questi sistemi per guadagnare.

Questo perché, molto più spesso di quanto si creda, le big tech companies producono prodotti competitivi, ma che non tengono sempre conto dei problemi riscontrati dagli utenti.

I repository GitHub di aziende come Google, Amazon, Apple, Microsoft e via dicendo, hanno centinaia di migliaia di issues tracciate e irrisolte. Issues orfane, problemi con risposte completamente inaffidabili, problemi chiusi senza la risposta dell’OP e documentazione illeggibile o inesistente.

La vera domanda a questo punto è se è possibile creare e sostenere comunità solide, ben funzionanti ed etiche sulla scala di StackOverflow?

Quello che è successo a StackOverflow è un allarme importante.

La priorità dovrebbe essere infatti quella di creare strumenti che seguano delle linee guida volte all’etica dell’IA, con lo scopo di proteggere i “luoghi” che sono fatti per servire, tra cui Stack Overflow.*

Come StackOverflow.

*Tecnicamente, StackOverflow è un’entità commerciale, ma la portata del suo modello di business non ne permette una classificazione al pari delle big companies tale da considerarlo strettamente commerciale ai fini di questo articolo.