Transformers: La Rivoluzione nell'elaborazione del linguaggio naturale

Scopri come i Transformers stanno rivoluzionando il campo dell’Intelligenza Artificiale, migliorando l’elaborazione del linguaggio naturale e aprendo nuove frontiere nel campo dell’apprendimento automatico.

TOC

- Introduzione al concetto di transformer

- Cos’è un Transformer?

- Vantaggi dei Transformers

- Utilizzo dei Transformers

- Confronto con Altri Modelli Neurali

- Conclusione

Introduzione al concetto di transformer

I transformers rappresentano una delle innovazioni più significative nel campo del deep learning e dell’elaborazione del linguaggio naturale (NLP).

Introdotti nel 2017 nel celebre articolo “Attention Is All You Need” di Vaswani et al., i transformers hanno rivoluzionato il modo in cui i modelli di intelligenza artificiale elaborano e comprendono le sequenze di dati, superando le limitazioni delle reti neurali ricorrenti (RNN) e delle reti neurali convoluzionali (CNN).

Cos’è un Transformer?

Un transformer è un modello di deep learning progettato per gestire sequenze di dati in modo efficiente.

A differenza delle RNN, che elaborano i dati in modo sequenziale, i transformers possono processare intere sequenze simultaneamente, grazie a un meccanismo noto come self-attention.

Questo approccio consente al modello di assegnare pesi diversi alle varie parti dell’input, determinando quali elementi sono più rilevanti per la comprensione del contesto.

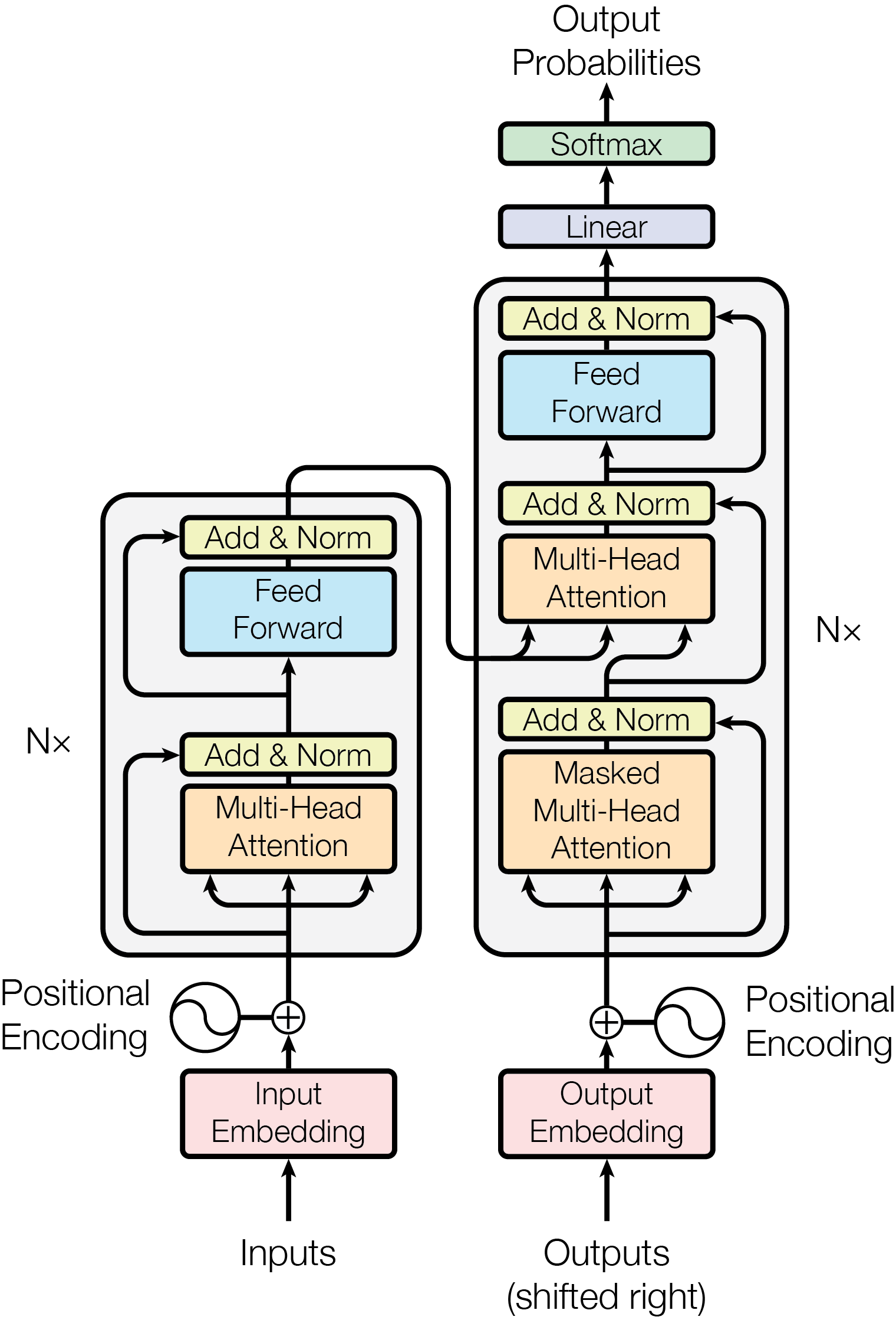

Componenti Chiave dei Transformers

- Self-Attention: Permette al modello di concentrarsi su specifiche parti della sequenza, migliorando la comprensione delle relazioni tra le parole.

- Positional Encoding: Poiché i transformers non elaborano i dati in ordine sequenziale, il positional encoding fornisce informazioni sulla posizione degli elementi nella sequenza, mantenendo il contesto necessario per l’interpretazione.

- Encoder e Decoder: La struttura del transformer è divisa in blocchi di encoder e decoder. Gli encoder elaborano l’input e generano rappresentazioni, mentre i decoder utilizzano queste rappresentazioni per produrre output.

Un articolo più dettagliato sul suo funzionamento e sull’architettura uscirà a breve.

Vantaggi dei Transformers

I transformers offrono numerosi vantaggi rispetto ai modelli precedenti:

- Parallelismo: La capacità di elaborare intere sequenze simultaneamente consente una maggiore efficienza durante l’addestramento e l’inferenza.

- Gestione delle dipendenze complesse: Grazie al meccanismo di self-attention, i transformers sono particolarmente abili nel catturare relazioni a lungo raggio all’interno dei dati, un aspetto critico per compiti complessi come la traduzione automatica e la generazione di testo.

- Scalabilità: I transformers scalano bene con l’aumento dei dati e delle risorse computazionali, rendendoli ideali per modelli di grandi dimensioni come GPT e BERT.

Utilizzo dei Transformers

Le applicazioni dei modelli basati su transformer sono vaste e in continua espansione:

- Traduzione automatica: I transformers hanno migliorato significativamente la qualità della traduzione automatica rispetto ai metodi precedenti.

- Generazione di testo: Modelli come GPT possono generare testi coerenti e contestualmente rilevanti basati su input forniti dagli utenti.

- Analisi del sentiment: Sono utilizzati per comprendere il sentiment nei testi, aiutando chi sviluppa e fa data sicence nelle analisi di mercato e nelle ricerche sociali.

- Conversational AI: Sono alla base degli assistenti vocali e delle chatbots avanzate che comprendono e rispondono alle richieste degli utenti in modo naturale.

Confronto con Altri Modelli Neurali

| Caratteristica | Transformers | RNN/CNN |

|---|---|---|

| Elaborazione Sequenziale | No, elaborano in parallelo | Sì, elaborano sequenzialmente |

| Gestione delle Dipendenze Lunghe | Eccellente | Limitata |

| Scalabilità | Alta | Variabile |

| Applicazioni Comuni | NLP, traduzione automatica | Visione artificiale |

Conclusione

I transformers hanno segnato un cambiamento radicale nel campo dell’intelligenza artificiale e dell’elaborazione del linguaggio naturale.

La loro capacità di gestire sequenze complesse in modo efficiente ha aperto la strada a nuove applicazioni e ha migliorato significativamente le prestazioni in vari compiti legati al linguaggio.

Con l’evoluzione continua della tecnologia, ci si aspetta che i transformers continuino a influenzare profondamente il panorama dell’IA, portando a innovazioni ancora più sorprendenti nel futuro.