In un precedente articolo, abbiamo parlato di come Ollama gestisce la memoria durante il caricamento e l’esecuzione dei modelli di linguaggio di grandi dimensioni (LLM).

Leggi

Tutti i risultati con a tema #ollama

In un precedente articolo, abbiamo parlato di come Ollama gestisce la memoria durante il caricamento e l’esecuzione dei modelli di linguaggio di grandi dimensioni (LLM).

Leggi

Guardare dietro le quinte di come funzionano i modelli di linguaggio di grandi dimensioni (LLM) è fondamentale per comprendere le loro prestazioni e limitazioni, e uno degli aspetti più critici è la gestione della memoria, che influisce direttamente sulla velocità di risposta e sulla capacità del modello di mantenere il contesto durante una conversazione.

Leggi

Ollama create Il comando più potente è quello che ci permette di creare un modello personalizzato partendo un Modelfile.

Leggi

Recap Nei primi due articoli abbiamo visto cos’è Ollama e come usarlo tramite CLI.

Leggi

Recap Nel primo articolo abbiamo visto cos’è Ollama e come installarlo.

Leggi

Cos’è Ollama? Ollama è uno strumento open-source che permette di eseguire modelli di linguaggio di grandi dimensioni (LLM) direttamente in locale sulla propria macchina.

Leggi

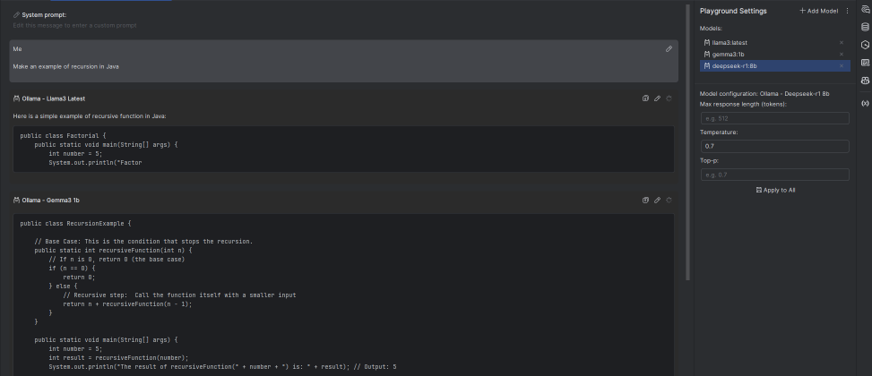

Hai già provato AI Playground di PyCharm? Scopri come usarlo con i modelli locali di Ollama per uno sviluppo assistito da LLM!

LeggiManda una mail a collaborazioni[at]theredcode.it con la tua proposta e diventa la prossima penna del blog!

Ma sì, facciamolo!